08.08.2019

.”Mennesker er ikke særlig gode til at identificere subtilt manipulerede videoer.”

Interview med Sam Gregory, direktør i WITNESS, et internationalt menneskerettigheds-netværk, og ekspert i artificiel intelligens og videoteknologi.

Interview af Christiern Santos Rasmussen

RÆSON: I kølvandet på filminstruktør og komiker Jordan Peeles’ “deepfake-video”, der viste en virkelighedstro Barack Obama advare mod netop deepfakes, var der megen debat om farerne ved denne nye teknologiske mulighed. Men hvad er – og hvordan virker – deepfakes mere præcist?

GREGORY: Deepfakes er egentlig en paraplybetegnelse for forskellige metoder, der netop bruger kunstig intelligens (AI) til at manipulere audiovisuel data. AI-teknologien bag er ofte det, vi kalder Generative Adversarial Networks (forkortet: GANs), hvilket helt lavpraktisk er et kapløb mellem to AI-systemer, hvor det ene skaber forfalskninger, og det anden forsøger at identificere dem. Produktet af denne konkurrence er den manipulerede audiovisuelle data. Der er delvist pga. denne konkurrenceprægede tekniske tilgang, at deepfakes er så potente redskaber til at lave forfalskninger, da de to AI-systemer tilsammen vil blive ved med at producere mere og mere virkelighedstro produkter.

Folk plejer at tænke på deepfakes som en ny måde at lave “face-swap” på, det vil sige, hvor man overfører en persons ansigt over på en andens – et kendt eksempel er online-videoer, hvor skuespilleren Nicolas Cages ansigt er blevet overført til andre skuespillere i forskellige film. Men ser vi på andre kommercialiserede redskaber til at lave audiovisuel manipulation, vil face-swaps ikke være det største problem – eller endda den mest udbredte form for anvendelse af deepfakes. Eksisterende redskaber til audiovisuel manipulation, som ikke er deepfakes, bruges allerede til at fjerne eller indsætte objekter i videoer, simulere virkelige menneskers stemmer, synkronisere folks stemmer eller mundbevægelser til lydsimuleringer – såkaldte lipsyncs – og få folk til at bevæge sig på bestemte måde – fx danse til musik eller få dem til at virke beruset.

RÆSON: Diskussionen om deepfakes har koncentreret sig om, hvordan disse forfalskninger kan misbruges. Der har været historier om et sort marked for deepfakes, hvilket har resulteret i, at flere uskyldige unge piger har fået deres ansigt klippet ind i pornografisk materiale. Hvor tilgængelig er deepfake-teknologien i dag?

GREGORY: Der er mange måder, hvorpå de her redskaber bliver mere tilgængelige. Deepfake-teknologien er baseret på en frit tilgængelig open source code – den originale kode blev først delt på Reddit og GitHub [en open-source kodeplatform, red.]. Det tillader kodere at udbygge den eksisterende kode og udvikle sine egne redskaber. Vi skal dog huske på, at der er adskillige legitime iværksættere og virksomheder, som kommercialiserer de her redskaber og gør det på en kontrolleret og ordentlig måde. Faresignalerne kommer derimod fra de her sortmarkeds-sider, du nævner. Der er hjemmesider, hvor du – for en lille afgift – kan uploade billeder af tilfældige mennesker og få lavet en deepfake-video af lav kvalitet og kraftig seksuel karakter, uden at det sker med samtykke fra de involverede.

Der er stadig tekniske barrierer for at kunne lave troværdige deepfakes, såsom adgang til data, tekniske færdigheder og stor processorkraft, men disse barrierer forandrer sig – og de gør det hurtigere end forventet. Særligt ift. de træningsdata, som AI-systemerne skal bruge til at ”øve” sig på, er mængdekravene faldet drastisk. Tidligere i år blev et studie udgivet, hvor forskere kun havde brug for 8-16 selfie-billeder til at lave en deepfake-video af lav kvalitet. Det havde ikke været muligt sidste år. Tager vi ydermere højde for kulturen på de sociale medier, hvor folk lægger masser af selfies op på deres offentligt tilgængelige profiler, så er vi faktisk i gang med at skabe en åben bank af den fornødne træningsdata – og dermed eksponerer vi os selv for ondsindede aktører. Og grundet de førnævnte sortmarkeds-sites er disse aktører heller ikke afhængige af at have de færdigheder eller den processorkraft, det kræver, for at lave deepfakes, da de kan købe sig til det.

Jeg arbejder meget med menneskerettighedsaktivister og undersøgende journalister, som allerede udsættes for falske anklager, fabrikeret materiale og andre forsøg på at undergrave deres omdømme og arbejde

_______

Det helt store vendepunkt kommer, når deepfake-teknologien bliver tilgængelig på vores mobiler. Det er (igen) vigtigt at huske på, at lignende teknologier allerede eksisterer, og at vi kan lære fra vores erfaringer med dem. Ser vi på Snapchats genderswap, hvilket er et redskab til audiovisuel manipulation af køn, fik filtret antallet af downloads af deres app til at eksplodere på meget kort tid. Kommer vi op på det niveau af tilgængelighed, er deepfakes ikke længere kun for forskere og nørder.

Men vigtigst af alt er at huske på, at forfalskningerne ikke behøver at være perfekte for at have en skadende effekt. Fra brugerstudier ved vi, at mennesker ikke er særlig gode til at identificere subtilt manipulerede videoer, og i andre tilfælde er det ligegyldigt, om materialet er forfalsket, for at udfylde sit formål: En pornografisk deepfake-video af lav kvalitet fra det sorte marked kan stadig være ret potent.

RÆSON: Kigger vi på de samfundseffekter og udfordringer, som deepfakes kan medføre, har mange tænkte scenarier været på banen – fra politiske skandaler til krigserklæringer forårsaget af falske videoer. WITNESS, hvor du arbejder, har udgivet en rapport, der pointerer, at disse udspringer fra to faktorer: 1) Evnen til at forfalske og 2) den manglende evne til at skelne. Hvad menes der med det?

GREGORY: Debatten om evnen til at forfalske audiovisuel data er nok den mest velkendte og udbredte. Når vi har lavet workshops om truslerne fra bevidst manipulation af audiovisuel data, har vi identificeret en lang række plausible scenarier, der kan forekomme på baggrund af disse trusler, såsom magtmisbrug i politiet, krigsforbrydelser, forfalskninger af politikere – for at miskreditere dem – og i kontekst med desinformationskampagner. Faren er her, at folk agerer på baggrund af forfalsket data, som var det sandt.

Her er det vigtigt at være opmærksom på de andre redskaber og mekanismer, som kan bruges i kombination af deepfakes og anden audiovisuel manipulation. Et eksempel er micro-targeting, hvor big data i kombination med personlige data bruges til at identificere individer, som har større tilbøjelighed at blive påvirket af dine forfalskninger, og som gør det muligt at designe materialet derefter. Det tillader ondsindede aktører at gå efter letpåvirkelige individer eller samfundsgrupper og dermed have en større effekt. Sammen med desinformationsstrategier og brugen af trolde og bots kan deepfakes potentiale virkelig være bekymrende.

Meget af denne debat har fokuseret på, hvad der kan ske, hvis sådanne scenarier berører toppolitikere. Men derfor udvikles mange af de tekniske tiltag, som skal beskytte potentielle ofre og identificere forfalskninger, også med henblik på at sikre individer på netop det niveau. Et eksempel er soft biometrics-tilgangen, hvor man bygger en beskyttet profil af folks karakteristiske kropssprog, og hvordan dette sammenfalder med måden, de taler på osv. – hvilket man så kan bruge til at identificere deepfakes. Denne teknologi er ikke tilgængelig for eller tiltænkt den brede befolkning, og jeg er bekymret for, at vi derved risikerer at ignorere de bredere og mere gennemtrængende farer ved deepfakes. Jeg arbejder meget med menneskerettighedsaktivister og undersøgende journalister, som allerede udsættes for falske anklager, fabrikeret materiale og andre forsøg på at undergrave deres omdømme og arbejde – noget, der kun vil forstærkes af deepfakes.

Den manglende evne til at skelne mellem manipuleret og ikke-manipuleret audiovisuelt materiale vil blive det næste store problem. Vi har allerede set politikere affærdige forskellige anklager ved at hævde, at bevismaterialet er deepfakes, og at man ikke kan stole på alt, hvad man ser. Et eksempel er sexvideoen af João Doria – en politiker fra Sao Paolo i Brasilien – der er i seng med fem forskellige kvinder. Han hævder, at videoen er en deepfake, og vi ved endnu ikke, om det er sandt. I en anden sag om en sexvideo fra Malaysia ser vi lignende mønstre, og de involveredes benægtelse er sandsynlig berettiget – men der er allerede skabt tvivl.

RÆSON: Hvordan spiller denne manglende evne til at adskille sandt fra falsk sammen med spørgsmålet om bevisbyrde?

GREGORY: Det kommer til at lægge et stort pres på allerede belastede systemer, hvilket særligt gælder retssystemet og pressen. Medierne presses allerede til at leve op til standarden om videregivelse af korrekt information i en tid med en overflod af ukorrekte oplysninger. Det pres vil intensiveres af et yderligere behov for at modbevise audiovisuel manipulation.

Hvad angår det retssystemet er problemet snarere et stigende behov for at finde metoder til at verificere beviserne – særligt når det er i den tiltaltes interesse at hævde, det er forfalsket. Vi har allerede set dette ske i USA specifikt med videomateriale af seksuel udnyttelse af børn. I det amerikanske retssystem behandles du anderledes, hvis der er tale om falske billeder, end hvis der ikke er. Det har skabt et smuthul i lovgivningen og lagt et større pres på anklagerens bevisbyrde. Men det her bliver virkelig et problem, når vi kigger på andre domstole og retssystemer, der kun lige er begyndt at bruge normale videoer som bevismateriale takket være spredningen af sociale medier og brugen af mobiler. Vi i WITNESS har kigget på domstole i Mellemøsten og Nordafrika, hvor normer og standarder omkring denne type af beviser er ved at udvikles, og som ikke har ressourcerne til dyre tekniske undersøgelser af bevismaterialets troværdighed. Det bliver et problem.

Lige nu investeres der mere i udviklingen af deepfake-teknologien end i identificeringen af deepfakes, hvilket vi skal rette op på. Men at finde en løsning kræver også koordination

_______

RÆSON: Hvor vigtigt er det så, at de tekniske tiltag for at beskytte og identificere er tilgængelige for pressen, NGO’er og domstole?

GREGORY: Det er en udfordring på flere niveauer. For det første er det vigtigt, at vi ruster det professionelle niveau og sikrer, at flere journalister, efterforskere og faktatjekkere har metoderne til at identificere audiovisuel manipulation. Men det skal gøres med et globalt perspektiv og ikke med et eksklusivt fokus på store mediekoncerner i USA og Europa.

Vi har også brug for en mere helhedsorienteret tankegang ift. vores samfund. Det er vigtigt, at nogle af de her redskaber udvikles på en måde, så det både bidrager til modstandskraften i vores samfund – i kombination med klassiske kildekritiske færdigheder – og giver mening for almindelige mennesker at bruge. For at gøre det sidstnævnte skal redskaberne være kompatible med flere platforme, så vi ikke ender i en situation, hvor det kun fungerer på Facebook, og majoriteten af brasilianerne får deres nyheder fra WhatsApp.

Men at gøre redskaber til at identificere deepfakes mere tilgængelige medfører også en risiko for, at ondsindede aktører kan anvende dem til at testkøre og forfine deres manipulerede produkter. At lave redskaberne både tilgængelige og meningsfulde uden at være overdrevent sårbare er en kæmpe udfordring. Lige nu investeres der mere i udviklingen af deepfake-teknologien end i identificeringen af deepfakes, hvilket vi skal rette op på. Men at finde en løsning kræver også koordination. Det gælder særligt, at de store sociale medieplatforme deler forfalskninger med udviklere af redskaberne til identifikation, som kan bruge dem som træningsdata.

Vi bliver også nødt til at tænke sikkerhed gennem diversitet. Intet redskab eller teknik vil være perfekt, og de vil altid være sårbare for misbrug af ondsindede aktører. Lige nu udvikles der både reaktive og proaktive identifikationsteknikker. Blandt de reaktive er der både tekniske undersøgelser, så som soft biometrics, der er også en deep learning-tilgang, hvor man basalt set bruger AI-teknologien bag deepfakes til at identificere manipuleret data.

Blandt de proaktive udvikles der forskellige metoder for digitale vandmærker, hvor et billede eller video gives en specifik digital signatur eller karakteristika, der ikke skal kunne forfalskes. I forlængelse heraf har mange talt meget varmt for brugen af blockchain – en teknologi, der er en form for digital åben regnskabsbog, der holder sporer transaktioner og ændringer til specifikke data [læs meget mere om blockchain hos RÆSON her, red.]. Her ville man kunne spore, hvornår data manipuleres og af hvem. Men det bør igen kun ses som en del af løsningen. For tilgangen er ofte forbundet med løsninger, der bygger på ideen om, at data kun er troværdig, hvis det har yderligere data om, hvor det kommer fra. I mit arbejde med menneskerettighedsaktivister kan jeg se en masse fuldt legitime scenarier, hvor man helst vil undgå at dele sådan informationer. Det bliver et problem, hvis vi ender med at affærdige disse mennesker, som med store personlige risici dokumenterer fx krigsforbrydelser, fordi de ikke ønsker at bruge redskaber, der fratager dem deres anonymitet.

Identifikationsredskaberne skal tænkes forsvarligt igennem og undgå at skabe en tilstand af mistænksomhed, hvor data kun kan stoles på, hvis det har et teknisk troværdighedsmærkat. Det er meget farligt, fordi det bidrager til problemet med at tro, at alt er løgn – især når andelen af den eksisterende misinformation er relativt lav. De tekniske redskaber skal bruges som signaler og ikke bekræftelse, så de gavner vores kilde kritiske sans og ikke forsøger at erstatte den.

Meget manipulation eksisterer uden at have reel indflydelse på sandhedsværdien af indholdet. Det vigtige er, hvilken effekt og hvilket formål manipulationen af materialet har – såsom at opildne til vold

_______

RÆSON: Du nævner de sociale medier som en del af løsningen. De første deepfakes cirkulerede på den pornografiske hjemmeside PornHub, som har forsøgt at forbyde deepfake-videoer. Men ifølge visse rapporter virker forbuddet ikke. Hvad kan de sociale medier gøre ved deepfakes?

GREGORY: Vi har indtil videre kun set deepfakes blive brugt i stor skala og uden samtykke på platforme så som PornHub. Men det giver os mulighed til at forberede og finde ud af, hvad vi som samfund vil have, at de sociale medier gør. Udover at koordinere identifikation af deepfakes og dele træningsdata om dette, så skal vi være enige om, hvad platformene skal fortælle sine brugere. Skal de informere brugere, når de eksponeres for manipuleret data og på hvilket niveau? Næsten alle billeder på Instagram er til en vis grad blevet manipuleret – enten med et filter, et redigeringsredskab eller noget tredje. Skal brugerne vide alt, bliver de nemt overvældet af information om irrelevant manipulation. Så vi skal finde ud af, hvornår manipulationerne er skadelige, og hvornår de er bagateller.

Et andet spørgsmål handler om censureringen af indhold. At seksuelt materiale, som laves uden samtykke med de involverede, ikke skal kunne deles på hverken PornHub eller Youtube, er ret ligetil. Men mange af de andre platforme er mere forskelligartede både i forhold til indhold og natur, hvilket gør, at vi skal være mere påpasselige med forbud af deepfakes på dem. Vi skal passe på med at lave et princip om, at problemet med deepfakes er manipulationens tekniske natur. Igen: Meget manipulation eksisterer uden at have reel indflydelse på sandhedsværdien af indholdet. Det vigtige er, hvilken effekt og hvilket formål manipulationen af materialet har – såsom at opildne til vold.

Der er mange aspekter i det her spørgsmål. Et er satirens rolle, som stadig skal have muligheden for at udfordre magthaverne ved at bruge de her redskaber. Et andet er håndhævelsen. Da de sociale medier begyndte at bruge AI til at fjerne terror-indhold på de sociale medier, fjernede filtreringsalgoritmerne også store mængder af billeddokumentation af krigsforbrydelser og brud på menneskerettighederne. Selvom AI har en rolle at spille i at censurere enorme mængder data, vil jeg være meget påpasselig med at ty til automatiseret fjernelse af deepfakes.

RÆSON: Mange af dine pointer læner sig op ad konsekvenserne for civile rettigheder i autokratiske samfund. Hvad er faren ved, at størstedelen af diskussionen om lovgivning af sociale medier finder sted i vestlige demokratiske samfund?

GREGORY: I både USA og EU er der særligt meget frustration over de sociale medier, og ofte ses de som negative for vores samfund ift. problemer med misinformation, censur og retten til privatliv. Men det er ikke nødvendigvis noget, som samfund uden for Vesten deler. Her læger mange derimod større vægt på demokratiserende muligheder, sociale medier tilbyder.

Når vi diskuterer lovgivning, skal vi være påpasselige med de indirekte effekter, dette kan have andre steder i verden. Vi skal undgå at formulere og introducere love, der hjælper autokratiske regimer med at kontrollere sine samfund og fjerne indhold på baggrund af tvivlsomme anklager om forfalskning. Vi har allerede set repressive love imod bloggere og om fjernelse af indhold i Tanzania og Singapore. Så vi har brug for at holde øje med de potentielle indirekte skader, som amerikansk og europæisk lovgivning kan medføre for andre samfund. ■

Vi har brug for at holde øje med de potentielle indirekte skader, som amerikansk og europæisk lovgivning kan medføre for andre samfund

_______

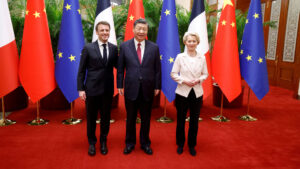

Sam Gregory (f. 1974) er direktør i WITNESS, et internationalt menneskerettigheds-netværk, og ekspert i artificiel intelligens og videoteknologi. ILLUSTRATION: Et screenshot af deepfake-video af Barack Obama [foto: Buzzfeed]

![Kampen om magten: „En meget berigende politisk bog […] Anbefales til indkøb‟](https://d.raeson.dk/wp-content/uploads/2020/02/usa.trump_-300x274.jpg)