29.12.2018

.Tech-industrien har gennem mange år hyldet disruption som et ubetinget gode, men disruption er ikke altid godt. Vi må bevæge os væk fra den forsimplede Silicon Valley-tankegang og i stedet indtænke teknologi i en humanistisk demokratisk tradition.

Af Dan Mygind

”Vi står over for intet mindre end en krise i vores demokrati – en vedvarende og ubønhørlig kampagne af disinformation og had rettet mod vores borgere, baseret på systematisk manipulation af borgernes data, uden at de har givet deres samtykke”. Ordene kommer fra det britiske konservative parlamentsmedlem Damian Collins, som er formand for den parlamentskomite, der blev nedsat i januar 2017 for at se nærmere på fake news. I juli 2018 udgav komiteen en foreløbig rapport om sit arbejde, og her kan man blandt andet læse, hvordan en række teknologier er blevet misbrugt til at underminere – eller disrupte – demokratier.

Det er kombinationen af dataindsamling fra sociale medier og andre datakilder samt psykologiske og adfærdsmæssige profileringsmetoder, der i dag gør det muligt at målrette budskaber til bestemte befolkningsgrupper/-typer. Da budskaberne spredes via sociale medier og kun ses af de få udvalgte, kan løgn og misinformation spredes, uden at budskabernes indhold kommer til offentlig debat. Dermed bliver det muligt at overbevise/skræmme/ophidse målgruppen med henblik på at opnå bestemte politiske mål. Som at få valgt en tidligere reality-tv-stjerne til præsident – eller få et land til at forlade EU.

Resultatet af det amerikanske præsidentvalg og Storbritanniens EU-afstemning var selvfølgelig i sidste ende udtryk for folkets vilje. Men i det skjulte foregik der en udemokratisk manipulation af vælgerne – foretaget af fremmede magter og lyssky private virksomheder. I både Storbritannien og USA har det – jf. Collins’ citat – vakt bekymring.

Denne artikel gennemgår andre måder, hvorpå informationsteknologien kan skade demokratiet. I Silicon Valley, tech-industriens centrum i nærheden af San Francisco, har man gennem mange år hyldet disruption. Kan man disrupte et eksisterende system, er det ubetinget godt. Ifølge Silicon Valley-logikken er et disruptet system per definition det nye underlegent – uanset hvordan det nye system er. Det er, mener jeg, en misforståelse. Vi må os bevæge væk fra den forsimplede teknokratiske Silicon Valley-tankegang og i stedet indtænke teknologi i en humanistisk demokratisk tradition.

Troen på et retfærdigt og humant samfundssystem kan langsomt eroderes af mindre beslutninger, som ikke har så store konsekvenser for den enkeltes liv

_______

Big data vokser med The Internet of Things

Big data bliver endnu større i de kommende år – huge data? – med et såkaldt ’Internet of Things’. Det sker, når fx ’smarte’ elmålere bliver installeret i vores hjem, og ’smarte’ biler ruller ud på vejene. Udviklingen skaber store fristelser for politikere og andre, der ønsker at ændre eller kontrollere en befolknings adfærd. De smarte elmålere opsamler løbende data om energiforbruget i et hjem og sender informationen om det enkelte hjems energiforbrug til en central datahub. Herfra kan der holdes øje med, hvornår hjemmets beboere står op, laver mad, går i seng og om der overhovedet er nogen hjemme.

Det gav hen over sommeren den danske regering en uigennemtænkt idé: Hvorfor ikke anvende smarte elmålere til at kontrollere, om modtagere af sociale ydelser rent faktisk bor på deres adresse? Nogle anvender såkaldte proformaadresser for at snyde sig til sociale ydelser, de ikke er berettiget til, fordi de reelt bor sammen med en partner på en anden adresse. Regeringen mente i første omgang ikke, at det var at skyde gråspurve med kanoner, at den relativt lille gruppe af sociale bedragere skulle godtgøre en overvågning af alle danskeres individuelle elforbrug. I anden omgang meldte beskæftigelsesminister Troels Lund Poulsen (V) ud, at oplysninger om elforbrug i private hjem kun må blive anvendt til efterforskning af snyd med sociale ydelser ved konkret mistanke.

Men smarte elmålere er blot ét af de mange apparater, der fra dit hjem sender data tilbage til datacentre i Danmark eller – som oftest – i udlandet. Nogle ’Internet of Things’-elementer kan vi slet ikke undgå, andre vælger vi af bekvemmelighed frivilligt at lukke ind i vores hjem.

Hvem lytter med?

Måske har du allerede sagt goddag til Amazons Echo eller Google Home. Det er små digitale enheder med mikrofoner, højttalere og måske et kamera og en skærm, som du kan placere rundtomkring i dit hjem. Du kan så tale med dem og fx spørge dem om, hvordan vejrudsigten ser ud for i dag.

Assistenterne lytter altid med, men data sendes i princippet kun tilbage til udbyderens datacenter, hvis du indleder din sætning med et bestemt ord. I Amazons tilfælde ”Alexa”, og for Google med et ”Hey Google” eller ”OK Google”. For at kunne svare bliver din tale sendt til et datacenter, hvor algoritmer analyserer dit spørgsmål. Herefter finder algoritmerne et svar, der sendes tilbage til den digitale assistents indbyggede højttaler. Det er den samme overordnede proces, som finder sted, når du aktiverer Siri på din iPhone. Som nævnt er det i princippet kun, når du anvender et bestemt ord eller en bestemt frase, at data sendes til udbyderens datacenter. Der kan dog opstå fejl. Ifølge Google var det eksempelvis en hardwarefejl, at Googles Home Mini optog alt, hvad tech-journalisten Artem Russakovskii sagde, og sendte optagelserne tilbage til Googles servere i oktober 2017. Journalisten havde fået de nyligt lancerede Home Minis til testning, og han kontaktede derfor Google for at høre, hvorfor Google Home blev aktiveret uden et ”OK Google”. Virksomhedsgiganten meddelte, at der var tale om en fejl, hvorefter de tilbagekaldte de nye Home Minis for at udbedre fejlen.

Det bliver interessant, når AI-systemers beslutninger skal forklares. Det er nemlig ikke altid, at udviklerne selv forstår, hvordan AI-systemet når frem til en beslutning

_______

Noget tilsvarende er sket med Amazons Echo. Et amerikansk ægtepar fik sig en overraskelse i maj i år, da en af mandens kollegaer kontaktede dem og sagde, at de øjeblikkeligt skulle slukke for deres Amazon Echo. Hvorfor? Fordi kollegaen via e-mail havde modtaget en optagelse af ægteparrets samtale. Afsenderen? Ægteparrets digitale assistent, Alexa. Ifølge Amazon var der tale om et usædvanligt sammentræf af begivenheder, som fik Amazon Echo til uopfordret at optage konversationen og derefter sende den til mandens kollega.

Udveksling af data mellem smarte enheder

Så de mange smarte apparater, der altså ikke er smartere, end at de nogle gange fejler, trænger sig efterhånden ind i vores hjem, og vi begynder at se samarbejde og udveksling af data mellem leverandører af Internet of Things-enheder. Eksempelvis har Google indgået samarbejde med iRobot, der udvikler de populære selvkørende Roomba-støvsugere. Roomba-støvsugerne indsamler data om indretningen af et hus, og Google vil anvende den information, så man eksempelvis kan sige til sin Google-assistent: ”Støvsug i dagligstuen”, hvorefter den sætter Roombaen til at støvsuge i dagligstuen. Google lover, at data om dit hjems indretning ikke vil blive anvendt til reklameformål.

Det er ikke kun smarte apparater i dit hjem, som forsyner centrale datacentre med oplysninger om dit elforbrug, dit hjems indretning, dine samtaler og anden adfærd. En ny bil er udstyret med en række sensorer, der opsamler data om din kørsel og din adfærd. General Motors fortalte for nylig, hvordan virksomheden har indsamlet oplysninger om, hvilke radiostationer folk lytter til, ligesom GM selvfølgelig har oplysninger om, hvornår og i hvilke landsdele bestemte programmer er mest populære.

Profileringen udbygges

Data om vores adfærd er guld værd for databrokere, der sælger personprofiler til annoncører, politiske organisationer og andre, der er interesserede i vores præferencer, adfærd og livsstil. Ligesom det var en stor fristelse for den danske regering at anvende data fra elmålere til at kontrollere borgere, er de digitale assistenter i vores hjem en stor datafristelse for Google, Amazon og Facebook. Netop Facebook, som faciliterede Cambridge Analyticas psykologiske profilering af amerikanske vælgere, har for nylig lanceret sin digitale assistent Portal, som er en højopløselig skærm med indbygget kamera, fire mikrofoner og højttalere. Hvor Cambridge Analytica indsamlede 87 millioner Facebook-brugeres data og anvendte de data til at udarbejde personprofiler for amerikanske vælgere, giver en digital assistent som Portal mulighed for indsamling af data om din offline adfærd og udbygge personprofileringen.

Tech-giganterne er da også begyndt at forberede sig på muligheden for en yderligere detaljering af personprofileringen. Eksempelvis har Amazon udtaget patent på at identificere, hvad folk kan lide og ikke lide, ud fra en analyse af deres tale. Der bliver på globalt plan udtaget enormt mange patenter, der ikke ender med at blive et produkt. Men Amazon har altså en patenteret metode til at analysere dine samtaler derhjemme. Der forskes i øvrigt i, hvordan neurale netværk kan diagnosticere eksempelvis depression ud fra en persons talemønster.

Stemmeanalyser afslører din sindstilstand

Amazon har da også udtaget et andet patent, der analyserer en brugers stemme for fysiske og følelsesmæssige karakteristika. Måske bliver det aldrig implementeret i et produkt, men forskningen er i gang, og når/hvis metoderne er gode nok, kan Amazon altså tilbyde at bestille hostesaft, hvis du hoster, eller måske antidepressive piller, hvis dit talemønster viser tegn på en depression.

Spørgsmålet er selvfølgelig, om sådanne metoder udelukkende vil blive anvendt til at servicere os bedre, eller om det er fristende at sælge personoplysningerne til andre end annoncører. Politiske partier og kampagneorganisationer vil være ivrige efter at høre, hvilke politikere du taler godt om, hvilke du bander over, og hvad din holdning er til forskellige politiske emner. Arbejdsgivere og forsikringsselskaber vil også gerne have flere oplysninger om dit fysiske og psykiske velbefindende. Fysiske helbredsoplysninger indsamles allerede ved hjælp af diverse fitness-trackers, der ved, hvor ofte du motionerer, din hvilepuls og anden helbredsmæssig information. Anvender du en af dem (eller en gadget, der holder øje med din kørsel), belønnes du med rabat på dine forsikringer).

Vi skal ikke være blinde for, at flere maskinbaserede beslutninger langsomt kan reducere det enkelte menneskes følelse af kontrol og øge en fremmedgørelse

_______

Hvem der har adgang til de indsamlede og ikke mindst afledte data i form af personprofilering, og hvad data samt personprofileringen bliver brugt til, er et af teknologiens helt store spørgsmål. Det er ikke nok med etiske principper eller guidelines om, hvordan data skal håndteres – det kræver lovgivning, da love forpligter virksomheder, mens principper og guidelines ikke er bindende. I USA er der faldet dom om, at data fra smarte elmålere skal opfattes som private. I Europa er EU’s Persondataforordning [GDPR, red.] et stort skridt fremad mod at sikre indsigt i, hvilke data der opbevares om den enkelte, men som eksempelvis dataaktivisten Paul-Olivier Dehaye har erfaret, så er det ikke enkelt at få adgang til alle oplysninger – fx hvilke websites du besøger – som Facebook har om os.

AI vil træffe flere beslutninger

De indsamlede data er ikke kun nyttige, når det handler om personprofilering. De er også nyttige, når det gælder udvikling af Artificial Intelligence (AI)-løsninger.

Vi kan forvente, at AI-algoritmer i stigende grad vil blive anvendt på flere samfundsområder til at træffe beslutninger eller give input til menneskelige beslutningstagere. Det er vigtigt, at mennesker, der berøres af den slags AI-genererede beslutninger, kan få en forklaring på, hvordan AI-systemerne er nået frem til afgørelserne. Det var ikke muligt, da et AI-system i 2016 besluttede, at en amerikansk fange ikke kunne prøveløslades, fordi systemet vurderede, at fangen ville begå ny kriminalitet. Algoritmen er en forretningshemmelighed, lød afvisningen til den fængsledes advokat, der forsøgte at finde ud af, hvad der lå til grund for systemets beslutning. Den slags er med til at nedbryde den sociale kontrakt mellem det enkelte menneske – fængslet eller ej – og staten.

Troen på et retfærdigt og humant samfundssystem kan også langsomt eroderes af mindre beslutninger, som ikke har så store konsekvenser for den enkeltes liv som en afgørelse om fortsat fængsling eller ej.

Eksempelvis er der iværksat et seks måneders pilotprojekt ved grænsekontrollen i Ungarn, Letland og Grækenland, hvor AI-systemet iBorderCtrl stiller spørgsmål til en grænsegænger og vurderer, om personen lyver. Hvis AI-systemet vurderer, at personen taler usandt, vil vedkommende blive afhørt af en menneskelig grænsevagt. Det er et pilotprojekt, og det har en menneskelig bagstopper, så der sker ikke umiddelbart noget ved, at omkring en fjerdedel af systemets beslutninger er forkerte. Men vi skal ikke være blinde for, at flere maskinbaserede beslutninger langsomt kan reducere det enkelte menneskes følelse af kontrol og øge en fremmedgørelse.

AI er ikke ufejlbarligt

AI-systemerne er langtfra ufejlbarlige, selvom leverandørerne ikke taler så meget om det, men forsøger at dupere ukritiske embedsmænd og politikere med ord som ’disruption’, der er blevet synonymt med en ubetinget positiv effekt.

Det er vigtigt at huske på, at AI-systemerne oplæres ved hjælp af data, og data kan være fejlbehæftede eller ikkerepræsentative, hvilket kan medføre, at systemet forstærker fordomme, som ligger implicit i de udvalgte oplæringsdata. Et gammelt it-mundheld gælder også for AI-systemer: Garbage in, garbage out. Fodrer du et system med dårlige eller utilstrækkelige data, får du dårlige eller utilstrækkelige svar.

Vi er langt fra en maskinbaseret generel intelligens, der overgår menneskets

_______

Igen kommer EU’s Persondataforordning europæerne til hjælp med dens ’Right To Explanation’, der kræver, at beslutninger truffet på baggrund af algoritmer skal kunne forklares til det involverede menneske, altså i modsætning til den fængslede i USA. Forordningen har dog kun været i kraft i seks måneder, og virksomheder samt datatilsyn har rigeligt at se til med blot at sikre, at følsomme persondata håndteres på betryggende vis. Men det bliver interessant, når AI-systemers beslutninger skal forklares. Det er nemlig ikke altid, at udviklerne selv forstår, hvordan AI-systemet når frem til en beslutning.

Trods megen hype om, at AI vil overtrumfe menneskelig intelligens i løbet af en overskuelig fremtid, er det værd at huske på, at vi er langt fra en maskinbaseret generel intelligens, der overgår generel menneskelig intelligens. Den generelle maskinbaserede intelligens – i modsætning til den specialiserede intelligens, som vinder over stormestre i skak og lignende – er, trods mange Hollywood-films påstand om det modsatte, faktisk ikkeeksisterende. Det er også værd at understrege, at menneskelig empati, etik og moralske overvejelser slet ikke eksisterer i AI-systemer.

Vi skal være mere realistiske om, hvad AI kan give os – og politikerne skal begynde at interessere sig for grundlæggende teknologiske realiteter.

Dødbringende autonome våben

Fraværet af menneskelig empati, etik og moralske overvejelser i AI-systemer gør politisk stillingtagen til en anden teknologisk udvikling meget presserende. Det er kun et spørgsmål om tid, inden AI træffer afgørelser, der bogstaveligt talt kommer til at handle om liv eller død.

Dræberrobotter eller Lethal Autonomous Weapons Systems (LAWS) er våbensystemer, der selv kan identificere mål og træffe afgørelse om at anvende dødelig kraft. Tæt på 4.000 forskere inden for robotteknologi og AI har skrevet et åbent brev til verdenssamfundet, hvori de advarer om, at anvendelsen af dræberrobotter eller dødelige autonome våbensystemer er lige på trapperne. I brevet hedder det blandt andet, at: ”Teknologien til kunstig intelligens (AI) har nået et punkt, hvor anvendelse af sådanne systemer er mulig inden for nogle år, ikke årtier”. Brevet er fra 2015.

Foreløbig uden held har FN forsøgt at få en international aftale i stand om anvendelse af dræberrobotter/LAWS, som forskerne kalder ’den tredje revolution i krigsførelse’ efter krudt og atomvåben. Organisationen Stop Killer Robots plæderer for et forbud mod udvikling og anvendelse af dræberrobotter, og mens FN ikke er kommet ud af stedet, så vedtog EU-Parlamentet i september en resolution, der opfordrer EU-landene og EU-Kommissionen til at støtte et forbud.

I modsætning til atomvåben kræves der nemlig ikke noget dyrt, svært tilgængeligt råstof til at udvikle dødelige autonome våben, og når produktionen først er i gang, vil de uundgåeligt dukke op på det sorte marked; tilgængelige for terrorister og kriminelle. ”Autonome våben er ideelle til snigmord, at destabilisere nationer, undertrykke befolkninger og selektivt dræbe etniske grupper. Vi mener ikke, at et militært AI-våbenkapløb er gavnligt for menneskeheden”, som det hedder i brevet.

24. september stillede jeg Udenrigsministeriet det enkle ja/nej-spørgsmål: ”Støtter Danmark et forbud mod dræberrobotter?”. Der kom et længere ikke-svar: ”Danmark har deltaget i ekspertgruppemøderne i april og august i Geneve og lægger sammen med EU vægt på bl.a. nødvendigheden af, at den potentielle udvikling og brug af sådanne våbensystemer lever op til international humanitær folkeret og menneskerettighederne”. Det er overraskende, at Danmark ikke følger EU-Parlamentets resolution, der blev støttet af 82 procent af EU-parlamentarikerne.

Diskret mediemanipulation og subtil fake news

Vi slutter, hvor vi startede. Med underminering af den offentlige diskurs vha. misinformation og fake news. Disse elementer kan blive sværere at afsløre i fremtiden grundet fremskridt inden for lyd- og videomanipulation. I 2016 demonstrerede Adobe eksempelvis programmet VoCo, som hurtigt blev kendt som ’Photoshop for lyd’. Med omkring 20 minutters lydoptagelse af en persons stemme, eksempelvis Barack Obamas, kunne programmet konstruere ord og små sætninger, som Obama aldrig havde sagt, men som programmet oplæste med Obamas unikke stemmemønster. En tilfældig tilhører ville tro, at det var Obama, der talte. Tilsæt videomanipulation i form af deepfakes, der på overbevisende facon placerer en persons ansigt på videooptagelser af en anden person. Resultatet kan bruges til at lave meget effektive fake news, der vil ændre folks virkelighedsopfattelser.

”Reality is a matter of perception” var sloganet for det nu lukkede firma Psy-Group, som arbejdede sammen med det ligeledes lukkede Cambridge Analytica om spredning af misinformation til personer, der var blevet personprofileret. De lukkede firmaers aktiviteter fortsætter dog formentlig (i virksomheder som Emerdata og White Knight).

Så hvad gør vi? I oktober bebudede regeringen, at der i løbet af 2019 vil blive nedsat et Dataetisk Råd. Det er et skridt på vejen til at tage hul på de beskrevne problemstillinger. Men etiske anbefalinger i et land, hvor teknologiansvaret smøres meget tyndt ud mellem otte ministerier, vil ikke have nogen effekt. Det kræver, at politikerne tager konkret stilling til udfordringerne, lovgiver for at sikre demokratiet og sørger for, at Danmark deltager aktivt i internationalt samarbejde om at imødegå de negative effekter af den nye teknologi. Disruption er ikke altid godt. ■

Hvem der har adgang til de indsamlede og ikke mindst afledte data i form af personprofilering, og hvad data samt personprofileringen bliver brugt til, er et af teknologiens helt store spørgsmål. Det er ikke nok med etiske principper eller guidelines om, hvordan data skal håndteres – det kræver bindende lovgivning

_______

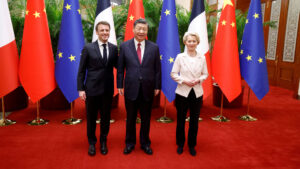

Dan Mygind (f. 1967) er journalist, datalog og forfatter. Twitter: @danmyg web:writeit.dk. ILLUSTRATION: Mark Zuckerberg, grundlægger og administrerende direktør i Facebook, tager plads ved en høring i Kongressen efter anklager om misbrug af brugerdata [FOTO: TOM BRENNER/NYTNS/RITZAU SCANPIX]

![Kampen om magten: „En meget berigende politisk bog […] Anbefales til indkøb‟](https://d.raeson.dk/wp-content/uploads/2020/02/usa.trump_-300x274.jpg)